八款主流数据迁移工具技术选型解析,助力数据处理技术开发

在当今数据驱动的时代,数据迁移工具的选择直接影响着数据处理项目的效率与质量。无论是系统重构、数据整合还是云上迁移,选对工具能事半功倍。本文将深入解析八款主流数据迁移工具,为技术开发人员提供全面的技术选型参考。

1. Apache NiFi

Apache NiFi是一款强大的数据集成平台,专注于数据流自动化。其图形化界面让用户能直观设计数据流,支持从多种数据源实时捕获、转换和路由数据。NiFi内置了丰富的处理器,涵盖数据格式转换、加密、压缩等场景。在技术选型中,NiFi适合需要复杂数据流编排、实时处理且对可视化操作有高要求的团队。

2. AWS Data Pipeline

作为亚马逊云服务的数据编排工具,AWS Data Pipeline专为AWS生态设计。它支持定期调度数据迁移任务,能无缝集成S3、RDS、DynamoDB等服务。对于已全面拥抱AWS云服务的企业,此工具能极大简化跨服务数据搬运流程,但其锁定在AWS生态内,跨云部署能力有限。

3. Talend

Talend提供开源和企业版的数据集成方案,以其强大的ETL(提取、转换、加载)功能著称。它支持超过900种连接器,涵盖数据库、SaaS应用、大数据平台等。Talend Studio提供可视化设计环境,生成的代码可部署到本地或云环境。在需要处理复杂数据转换且追求高可扩展性的项目中,Talend是优秀选择。

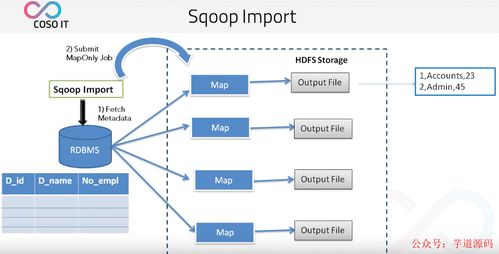

4. Apache Sqoop

专为Hadoop生态设计,Apache Sqoop能在关系型数据库(如MySQL、Oracle)与Hadoop(HDFS、Hive、HBase)之间高效传输批量数据。其命令行界面简洁,适合已有Hadoop技术栈且主要进行结构化数据迁移的场景。不过,Sqoop对非关系型数据库支持有限,且更侧重批量而非实时迁移。

5. Google Cloud Dataflow

基于Apache Beam模型,Google Cloud Dataflow提供全托管的数据处理服务,支持批处理和流处理。其统一编程模型让开发者能编写一次代码,在批量和实时场景中运行。对于追求弹性伸缩、希望简化基础设施管理的团队,Dataflow能有效降低运维负担,尤其适合已使用Google Cloud Platform的企业。

6. Apache Kafka Connect

作为Apache Kafka生态系统的一部分,Kafka Connect专注于在Kafka和外部系统之间构建可扩展、可靠的数据管道。它提供大量现成连接器,支持分布式部署和故障恢复。在需要构建实时数据管道、强调低延迟和高吞吐量的场景中,Kafka Connect是理想选择,尤其适合已有Kafka作为数据中枢的架构。

7. Azure Data Factory

微软Azure的云数据集成服务,提供无代码界面和代码编辑两种模式。它能协调跨本地和云环境的数据移动,内置了数据流功能,支持视觉化设计数据转换逻辑。对于深度使用微软技术栈(如SQL Server、Power BI)的企业,Azure Data Factory能实现无缝集成,提供端到端的数据解决方案。

8. Hevo Data

作为新兴的SaaS数据管道平台,Hevo Data主打零代码和分钟级部署。它提供150多种预建连接器,支持自动模式检测和数据类型映射。Hevo适合需要快速搭建数据管道、缺乏专门数据工程团队的中小企业,但其定制化能力和对复杂场景的支持相对有限。

技术选型建议

选择数据迁移工具时,需综合考虑以下因素:

- 数据源与目标:评估工具对现有及未来数据系统的支持度。

- 处理模式:明确需求是批量、实时还是混合模式。

- 技术栈兼容性:确保工具与现有基础设施和团队技能匹配。

- 成本与许可:平衡开源工具的灵活性与商业工具的服务支持。

- 可扩展性:考量数据量增长和未来业务变化的需求。

数据处理技术的开发趋势正朝着自动化、实时化和云原生方向发展。掌握这些工具的特性,结合具体业务场景,才能做出明智的技术选型,真正实现“yyds”(永远的神)级别的数据处理效能。在实践中,往往需要组合使用多种工具,构建端到端的数据管道,以应对日益复杂的数据生态挑战。

如若转载,请注明出处:http://www.yingling8888.com/product/52.html

更新时间:2026-02-24 06:20:28